Google développe un algorithme qui peut dire avec précision où vos photos ont été prises,

PlaNet n'utilise que très peu de mémoire RAM

Si vous prenez une photo sur internet et que vous essayez de deviner où elle a été prise, la tâche sera évidente si vous remarquez un bâtiment (tour Eiffel, tour de Pise) ou si vous avez un point de repère (chute du Niagara). Mais elle deviendra beaucoup plus compliquée si la photo manque de marqueurs spécifiques de localisation.

Une équipe de deux employés Google et d'un chercheur de l'Université RWTH Aachen en Allemagne ont mis sur pied un algorithme capable d'analyser une image et d'estimer où elle a été prise avec un très grand degré de précision. Cet algorithme a été développé dans le cadre du projet baptisé PlaNet.

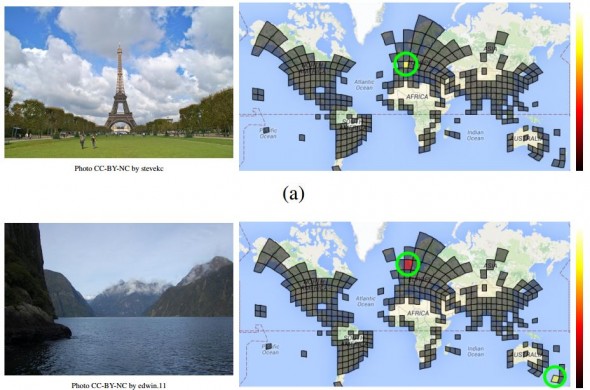

Dans le monde de l'apprentissage automatique, leur méthode est assez simple : ils ont commencé par diviser le monde en 26 000 carrés de diverses tailles où la probabilité est élevée qu'un grand nombre de photos puissent être prises dans ces endroits. Par exemple, les grandes villes, qui sont susceptibles de générer plus de photos, avaient une structure de grille plus fine que celles des régions reculées où la probabilité de prendre des photos s'avère moins importante. D'ailleurs, l'équipe a décidé d'ignorer des régions comme les océans et les régions polaires où peu de photos sont susceptibles d'être prises.

Par la suite, l'équipe a créé une base de données d'images géolocalisées prises sur le web (plus de 91 millions d'images Flickr qui contenaient des données de géolocalisation) et s'est servie des données de géolocalisation pour déterminer le carré dans lequel chaque image a été prise. L'idée sous-jacente était de faire évoluer l'apprentissage de PlaNet afin qu'il puisse se servir de marqueurs subtils sur une image pour déterminer le carré dans lequel elle a été prise ou un ensemble de carrés dans lesquels elle aurait pu être prise.

Après avoir fini l'apprentissage de PlaNet, les chercheurs se sont servis de 34 autres millions d'images pour tester leur système afin de voir à quel point leur algorithme pouvait être précis. « PlaNet est en mesure de localiser 3,6 pour cent des images avec une précision qui va jusqu'au nom de la rue où elles ont été prises, et 10,1 pour cent des images avec une précision qui va jusqu'au niveau de la ville où elles ont été prises », ont indiqué les chercheurs. De plus, l'algorithme est capable de déterminer le pays d'origine sur 28,4 pour cent des photos et le continent sur 48,0 pour cent d'entre elles.

Pour montrer à quel point ces statistiques sont encourageantes, les chercheurs ont mis PlaNet à l'épreuve face à dix humains qui ont beaucoup voyagé de par le monde. Pour le test, ils ont créé GeoGuessR, un jeu en ligne dans lequel une image est tirée de façon aléatoire du Google Street View et le joueur est prié de repérer son emplacement sur une carte du monde.

« En tout, PlaNet a remporté 28 manches sur les 50 avec une erreur médiane de localisation de 1131,7 km, tandis que l'erreur médiane de localisation de l'homme était de 2320,75 km. Cette expérience à petite échelle montre que PlaNet atteint des performances surhumaines dans la tâche de repérer des paysages sur Google Street View », se sont réjouis les chercheurs.

Une question intéressante est de savoir comment PlaNet fait pour avoir un tel rendement sans se servir de marqueurs utilisés par les humains comme la végétation, le style architectural, etc. Ce à quoi les chercheurs ont répondu en disant « nous pensons que PlaNet a un avantage sur l'homme parce qu'il a vu bien plus d'endroits qu'un humain ne pourrait jamais visiter et il a noté des marqueurs subtils de différents paysages qui peuvent s'avérer très difficiles à distinguer même pour un humain qui a beaucoup voyagé ».

Tout ceci en se servant d'une petite quantité de mémoire contrairement aux services qui nécessitent de grosses quantités : « notre modèle n'utilise que 377 Mo de mémoire, ce qui peut même suffire dans la mémoire d'un smartphone ».

Essayer GeoGuessR

Source : Discovery News, papier blanc (au format PDF)

Répondre avec citation

Répondre avec citation

Partager