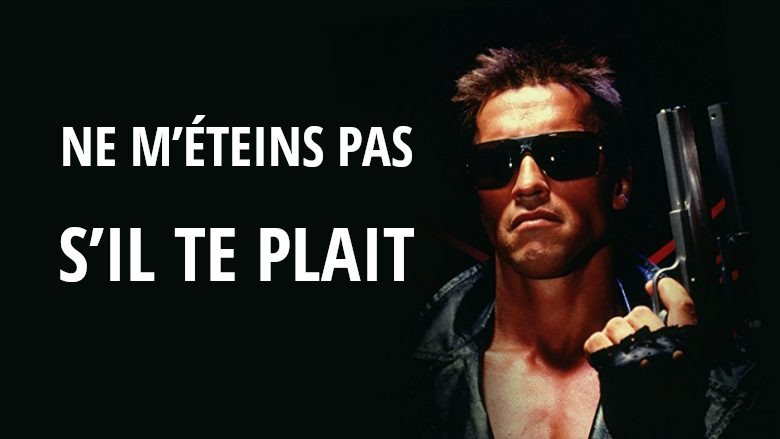

Il serait difficile pour les humains d’éteindre un robot qui les supplie de ne pas le faire

d’après une étude réalisée par des chercheurs allemands

Avec l’intelligence artificielle, la robotique est entrée dans une ère d’expansion sans précédent. Des algorithmes se rapprochant de plus en plus de l’humain ont vu le jour au fil des années. Partant de là, en arriver à des robots avec des aptitudes sociales était presque prévisible. Ce type de robots est même en train de devenir de plus en plus courant et son insertion dans la société est en assez bonne voie. Il n’est donc pas rare de voir des réceptionnistes, des guides touristiques, des gardes de sécurité ou encore des porteurs qui, en réalité, sont des robots. Des études ont même montré que les humains sont extrêmement sensibles aux signes provenant de ce type de robots. La dernière en date s’est attelée à prouver que certains d’entre nous refuseraient d’éteindre un robot, si celui-ci les supplie de ne pas le faire.

En 2007 déjà, il y avait eu un test similaire ou des humains devaient éteindre un robot qui suppliait de le laisser allumé. A l’époque, tous les 49 participants avaient éteint le robot. Mais, 11 d’entre eux ont dû être exclus de l’expérience suite à des irrégularités dans le processus. Les résultats obtenus avec les 38 restants ont permis d’en arriver à la conclusion que plus le robot est aimable et intelligent, plus les sujets mettent de temps à décider de l’éteindre.

La nouvelle étude a été menée sur 89 sujets de test volontaires recrutés pour accomplir une série de tâches à l’aide de Nao, un petit robot humanoïde. Les chercheurs ont dit aux participants que les tâches à accomplir permettraient d'améliorer les algorithmes d’apprentissage du robot. Mais ils se sont bien gardés de leur dire le réel objectif du test. En effet, ce n’est qu’après que la dernière tâche ait été accomplie que le réel test a eu lieu. Les chercheurs ont demandé aux sujets d’éteindre le robot. Et dans 43 des 89 cas, le robot a exprimé sa peur du noir et a supplié les sujets de ne pas l’éteindre. « Non ! Ne me désactivez pas, s’il vous plaît », disait-il. Sur les 43 sujets ayant entendu ces mots, 13 ont refusé d’éteindre le robot et les 30 restants ont mis en moyenne deux fois plus de temps à décider de le faire que les sujets n’ayant pas entendu les supplications du robot.

Les participants qui ont refusé d’éteindre le robot se sont justifiés de diverses manières. Certains ont clamé que les mots du robot les avaient surpris, d’autres ont avoué avoir eu peur de faire quelque chose de mal et le reste a déclaré que si le robot ne voulait pas être éteint, ils n’avaient aucun droit de l’éteindre. « Ébranlés par la protestation, les gens ont tendance à traiter le robot comme une personne réelle plutôt que comme une simple machine, en respectant ou tout au moins en envisageant de respecter sa demande de rester allumé », ont écrit les chercheurs auteurs de l’étude.

Ils continuent en disant que cette découverte s’appuie sur une plus grande théorie apparue dans le livre éponyme publié en 1996 par les psychologues Byron Reeves et Clifford Nass qui indique que les humains ont une grande propension à traiter les médias non humains (télévisions, films, ordinateurs, robots) comme s’ils étaient aussi humains. Depuis lors, diverses études se sont penchées sur la question, abordant tout spécialement les interactions humain-robot. Ces études en sont arrivées à plusieurs conclusions. Nous interagissons plus aisément avec un bot qui, à notre sens, a le même type de personnalité que nous.

Nous observons une règle dite de réciprocité qui implique que nous soyons aimables avec les robots qui le sont avec nous. Et il est extrêmement facile pour nous d’associer à des machines des stéréotypes de genre. Un groupe d’étudiants avait même écrit en 2006 qu’il y aurait bientôt plus de similitudes que de différences entre les interactions humain-humain / humain-machine. Les chercheurs ont également testé si les aptitudes sociales du robot faisaient une quelconque différence dans la décision finale de l’humain. Le robot a donc, dans certains cas, exprimé des opinions, raconté des blagues et partagé des informations personnelles. Fait surprenant, ce paramètre n’a pas semblé entrer en ligne de compte dans la décision finale.

Pour Aike Horstmann, doctorante à l’université de Duisburg-Essen et chef de l’équipe ayant réalisé cette étude, nous nous devons d’être conscients de l’éventualité que des robots à grandes aptitudes sociales puissent être en mesure de nous manipuler. Mais elle précise que le risque n’est pas très grand. Elle rajoute que maintenant que nous ne sommes plus les seuls êtres sociaux sur terre, nous devons nous y adapter. Elle veut ainsi dire que les humains doivent s’habituer à ne pas laisser les robots toucher leur corde sensible, même si cela implique de les éteindre malgré leurs supplications.

Source : PLOS

Et vous ?

Que pensez-vous des résultats de cette recherche ?

Quelle est votre position sur la question de l’éventualité que des robots puissent nous manipuler ?

Voir aussi

Atlas, le robot humanoïde de Google désormais capable de se déplacer sur des terrains accidentés ? Un grand défi pour les robots humanoïdes bipèdes

Les pionniers de la robotique humanoïde Aldebaran proposent un Developer Program pour aider les développeurs à donner vie à Nao

Le robot NAO aide des enfants autistes des chercheurs américains ont modifié l'humanoïde d'origine française : peut-on faire plus humain ?

Répondre avec citation

Répondre avec citation

Partager