Google décide d’offrir son aide pour la gestion des aspects controversés en matière d’éthique de l’intelligence artificielle

Via un service dédié que l’entreprise entend lancer avant la fin d’année

Google prévoit de lancer un service en ligne en matière d’éthique de l’intelligence artificielle d’ici à la fin de l’année en cours. Ce dernier est destiné à conseiller ses clients sur la manière d’opérer le repérage de préjugés raciaux dans les systèmes de vision par ordinateur et à l’élaboration des directives éthiques pour les projets dans le domaine de l’intelligence artificielle. La société pourrait également proposer d'auditer les systèmes d'IA de ses clients pour vérifier leur intégrité éthique et facturer la fourniture de conseils en matière d'éthique. Comme une note d’ironie ? On serait tenté de répondre par l’affirmative quand on se retourne sur le passé de l’entreprise dans la filière.

La première série de services de l'entreprise comprendra des cours de formation sur des sujets tels que la manière de repérer les problèmes éthiques dans les systèmes d'intelligence artificielle, de développer et de mettre en œuvre des directives éthiques en matière d’IA. Le contenu serait similaire à celui proposé aux employés de la firme de Mountain View. En sus, Google prévoit d’offrir des services d’examen et d’audit, mais ce sera pour plus tard. Tracy Frey, directrice de la stratégie produit et des opérations de Cloud AI chez Google, confirme.

L’initiative en cours de gestation chez le géant de la filière technologique fait suite à la publication il y a plus de deux ans d’un guide éthique en matière d’intelligence artificielle. L’entreprise répondait alors aux protestations contre sa participation à un projet du Pentagone. L'adhésion à ces principes avait ralenti le lancement des produits de Google, ce, parfois avec des pertes de revenus à la clé. Par exemple, en 2019, Google a lancé un service de reconnaissance faciale limité aux célébrités. L'examen éthique et le processus de conception de ce dernier ont pris 18 mois. Le processus d'examen a nécessité du temps, notamment, pour résoudre un problème de données fournies à l’IA lors de la phase d’entraînement, ce qui a entraîné une baisse de précision dans la reconnaissance des acteurs masculins noirs. En conséquence, au moment où Google lançait son service, celui d'Amazon était ouvert à tous depuis plus de deux ans.

Google est cité par un article de l’Union américaine des libertés civiles (UCLA) comme l’entreprise dont le moteur de recherche (et d’autres produits) alimenté à l’intelligence artificielle perpétue le racisme basé sur la discrimination en lien avec les biais de données. C’est aussi la société que l’on pointe du doigt pour n’avoir pas pu trouver de solution au comportement de son algorithme qui étiquetait les noirs comme des gorilles et qui empêchait donc Google Photos et d'autres de ses produits d'étiqueter une image comme étant un gorille, un chimpanzé ou un singe, même lorsqu'il s'agissait de photos des primates eux-mêmes.

Après l'annonce d'IBM de cesser de proposer des logiciels de reconnaissance faciale en réponse au mouvement Black Lives Matter, l'entreprise a été suivie par Amazon et son moratoire sur l'utilisation par la police de son système de reconnaissance faciale controversé – Rekognition. Microsoft aussi avait pris position en refusant de vendre cette technologie aux services de police en l'absence de loi. Google, cependant, a brillé par son absence lors de ces rendez-vous, malgré la demande de plus de 1500 de ses employés de cesser de vendre sa technologie aux services de police.

Autre exemple : Google a travaillé sur Project Dragonfly – un moteur de recherche spécifique à la Chine - qui devait s’aligner sur les règles de censure chinoises. L’entreprise n'a confirmé l'arrêt du projet qu'en juillet 2019, après avoir été critiquée par ses propres employés et des organisations mondiales de défense des droits comme Amnesty International.

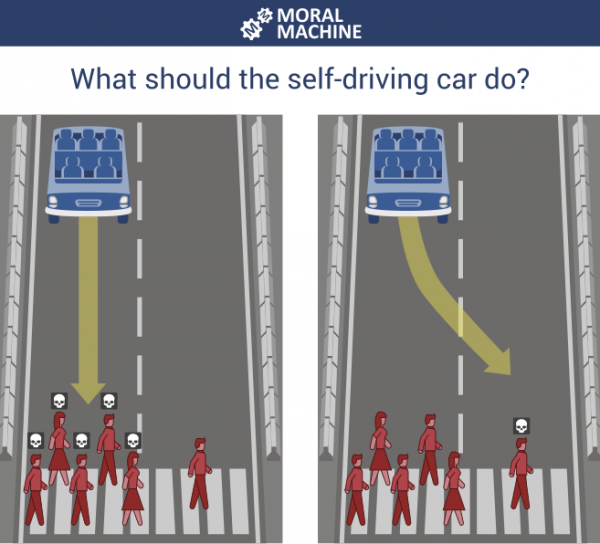

Il sera donc intéressant de voir comment la firme de Mountain View parviendra à drainer du monde sur son service d’éthique en matière d’intelligence artificielle et apporte réponse à des problématiques comme celle du dilemme du tramway. Les chercheurs du MIT Media Lab se sont inspirés de ce problème classique pour tester neuf différentes situations : la voiture autonome en passe de faire un accident devrait-elle épargner en priorité les humains plutôt que les animaux de compagnie, les passagers au lieu des piétons, les femmes au lieu des hommes, les jeunes plutôt que les vieux, les personnes ayant un haut statut social au lieu de celles ayant un statut inférieur, les personnes respectant la loi plutôt que les criminels, les personnes mal portantes au lieu de celles en bonne santé ? La voiture devrait-elle dévier (agir) ou ne rien faire ou encore chercher à épargner le plus de vies possible ?

En tout cas, après les SaaS et autres PaaS, l’initiative de Google aura au moins eu l’initiative de lancer un nouveau sigle – EaaS pour Ethical AI as as Sarvice.

Source : Tracy Pizzo Frey

Et vous ?

Que pensez-vous de cette initiative ?

Voir aussi :

IA : un guide éthique en développement chez Google pour répondre aux protestations contre la participation de l'entreprise à un projet du Pentagone

Google dissout son conseil d'éthique de l'IA une semaine à peine après sa mise en place suite à un mouvement collectif d'indignation

Oracle finance une initiative anti-Google pour mettre à nu les pratiques non éthiques et le lobbying exercé par le géant de la recherche en ligne

Google promet de ne pas utiliser l'IA pour le développement d'armes, mais informe qu'il va continuer à coopérer avec les militaires

Répondre avec citation

Répondre avec citation

Partager