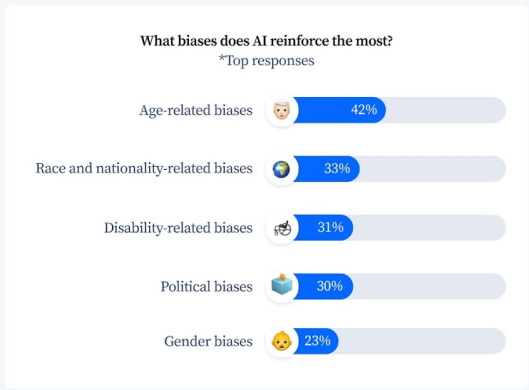

98 % des gens estiment que l'IA a hérité des biais humains en raison des données qui l'alimentent, et 45 % pensent que c'est le plus gros problème de l'IA, selon une enquête de Tidio

Beaucoup semblent avoir l'impression que l'IA peut nous aider à prendre de meilleures décisions. Après tout, qu'est-ce qui peut être plus objectif qu'une machine ? Eh bien, des études ont montré que l'IA peut être sujette à des préjugés, tout comme les êtres humains. Ce sont les humains qui entrent les données pour alimenter son algorithme d'apprentissage automatique en premier lieu, il est donc logique qu'elle commence à apprendre beaucoup des préjugés sous lesquels nous fonctionnons.

Une enquête menée par Tidio a révélé que 98 % des gens pensent que l'IA est biaisée. 45 % des personnes qui ont répondu à cette enquête ont déclaré qu'il s'agissait en fait du plus gros problème de l'IA, et 40 % ont ajouté que ce sont les développeurs qui sont responsables de ces préjugés, même si tout a été considéré et pris en compte.

Les ensembles de données utilisés pour former l'IA sont en partie responsables. Ils contiennent tous nos biais, et ils allaient certainement se manifester lorsque l'IA a commencé à les utiliser.

Malgré cela, les itérations les plus récentes de l'IA, développées par Open AI, sont prometteuses. Lorsqu'on lui a demandé de montrer un PDG ambitieux, par exemple, l'IA a fini par représenter un homme noir ainsi qu'une femme portant des vêtements professionnels. Ceci est très probablement dû à un effort conscient d'Open AI pour réduire les biais dans DALL-E.

Cependant, Stable Diffusion a manifestement beaucoup de travail à faire, puisqu'elle n'a représenté que des hommes blancs d'âge moyen lorsqu'elle a reçu cette demande. Lorsqu'on lui demande de représenter une infirmière, elle ne montre que des femmes. C'est un signe évident de partialité, et cela suggère que les personnes derrière Stable Diffusion ne font pas assez d'efforts pour y remédier.

Des changements doivent être apportés si l'IA doit passer au niveau supérieur. Sinon, elle ne sera qu'une représentation avancée des mêmes vieux préjugés avec lesquels nous vivons depuis des milliers d'années.

Source : Tidio

Et vous ?

Selon vous, cette enquête de Tidio est-elle pertinente ?

Pensez-vous qu'il soit possible d'améliorer les systèmes d'IA pour qu'ils n'intègrent pas de préjugés ? Si oui, quels peuvent en être les risques ?

Voir aussi :

L'IA peut-elle éliminer les biais dans le processus de recrutement ? Non, d'après une étude qui estime que le logiciel de recrutement d'IA est une « pseudoscience automatisée »

L'intelligence artificielle peut-elle aider à rendre les décisions de justice moins biaisées ? Oui, selon un expert

Des chercheurs en IA améliorent la méthode permettant de supprimer les préjugés sexistes dans les systèmes conçus pour comprendre et répondre aux données textuelles ou vocales, selon une étude

Répondre avec citation

Répondre avec citation

Partager