Des développeurs créent un système d'IA pour générer des croquis de suspects pour la police, mais les experts sont horrifiés

et affirment que cela pourrait aggraver les préjugés raciaux et sexistes

La question de savoir si la police peut faire appel ou non à l'IA pour identifier et arrêter un suspect est de nouveau remise sur le tapis. En effet, deux développeurs ont utilisé le modèle de génération d'images DALL-E 2 d'OpenAI pour mettre au point un programme qui crée un portrait très réaliste d'un suspect en fonction des données entrées par l'utilisateur. Ils affirment que leur système d'IA peut réduire considérablement le temps d'esquisse, qui prend généralement 2 à 3 heures, mais les experts ont souligné que le réalisme pourrait en fait entraver l'enquête. Ils ajoutent en outre que cela pourrait aggraver les préjugés raciaux et sexistes qui minent déjà la police.

DALL-E, nommé d'après Salvador Dali et le personnage de robot WALL-E de Pixar, est un modèle d'apprentissage automatique créé par OpenAI. DALL-E a été lancé en janvier 2021, mais n'avait jamais été disponible pour une utilisation publique. Une version actualisée et plus avancée, DALL-E 2, a été lancée en avril 2022. DALL-E 2 a été entraîné sur 650 millions d'images. DALL-E 2 est basé sur GPT-3, un modèle de langage qui permet à un ordinateur de comprendre un texte écrit par un humain, le relier à des concepts existants et produire des visuels originaux. DALL-E 2 crée quatre images différentes, et vous pouvez choisir celle qui vous plaît le plus.

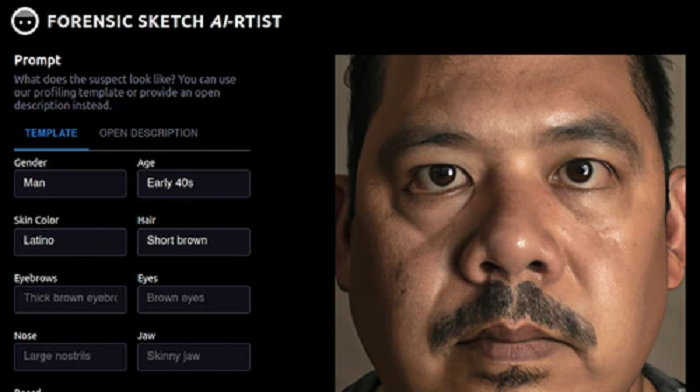

Cela fait de DALL-E 2 un outil puissant pour diverses applications dans des domaines tels que la vision par ordinateur, le graphisme et la conception Web. Cependant, il a récemment été utilisé par des développeurs pour mettre en place un système de génération de croquis de suspects de police qui soulève des préoccupations d'ordre éthiques. Le programme, appelé "Forensic Sketch AI-rtist", a été mis au point par les développeurs Artur Fortunato et Filipe Reynaud dans le cadre d'un hackathon en décembre 2022. Les développeurs ont écrit que le but du programme est de réduire le temps habituellement mis pour faire le croquis du suspect d'un crime.

« Nous n'avons pas encore publié le programme, donc nous n'avons pas d'utilisateurs actifs pour le moment. À ce stade, nous essayons toujours de valider si ce projet serait viable à utiliser dans un scénario du monde réel ou non. Ainsi, nous prévoyons d'entrer en contact avec les services de police afin d'avoir des données d'entrée sur lesquelles nous pouvons le tester », ont déclaré Fortunato et Reynaud à Motherboard dans un courriel commun. Cependant, des éthiciens et des chercheurs en IA soulignent que l'utilisation de l'IA générative dans la police scientifique est dangereuse, avec le potentiel d'aggraver les préjugés raciaux et sexistes existants.

« Le problème des croquis médico-légaux traditionnels n'est pas qu'ils prennent du temps à produire (ce qui semble être le seul problème que ce programme de croquis médico-légaux d'IA tente de résoudre). Le problème est que tout croquis médico-légal est déjà soumis aux préjugés humains et à la fragilité de la mémoire humaine. L'IA ne peut pas résoudre ces problèmes humains, et ce programme particulier va probablement les aggraver par sa conception même », note Jennifer Lynch, directrice des litiges relatifs à la surveillance de l'Electronic Frontier Foundation (EFF). Selon elle, les humains ne se souviennent pas des visages par caractéristiques.

Lynch estime que les humains se souviennent de l'ensemble du visage comme d'un tout. Mais le programme demande aux utilisateurs de fournir des informations soit par le biais d'un modèle qui demande le sexe, la couleur de la peau, les sourcils, le nez, la barbe, l'âge, les cheveux, les yeux et les descriptions de la mâchoire ; soit par le biais de la fonction de description ouverte, dans laquelle les utilisateurs peuvent taper toute description qu'ils ont du suspect. Il peut ensuite cliquer sur "générer un profil", ce qui envoie les descriptions à DALL-E 2 et produit un portrait généré par l'IA. Selon les experts, le système peut conduire à des arrestations arbitraires.

« Des recherches ont montré que les humains se souviennent des visages de manière globale, et non caractéristique par caractéristique. Un processus d'esquisse qui repose sur des descriptions de caractéristiques individuelles, comme ce programme d'IA, pourrait aboutir à un visage étonnamment différent de celui de l'auteur du crime. Malheureusement, une fois que le témoin voit le portrait-robot, cette image peut remplacer dans son esprit son souvenir flou du véritable suspect. Ce phénomène n'est qu'exacerbé par une image générée par l'IA qui semble plus beaucoup plus réaliste qu'un croquis dessiné à la main », a déclaré Lynch.

Selon les analystes, la création de profils de suspects hyperréalistes ressemblant à des personnes innocentes serait particulièrement préjudiciable aux Noirs et aux Latinos, les Noirs étant cinq fois plus susceptibles d'être arrêtés par la police sans motif qu'une personne blanche. Les personnes de couleur sont également plus susceptibles d'être arrêtées, fouillées et soupçonnées d'un crime, même lorsqu'aucun crime n'a été commis. Lynch affirme que les identifications erronées par des témoins oculaires ont contribué à 69 % des condamnations injustifiées qui ont ensuite été annulées par des preuves génétiques aux États-Unis.

Plus précisément, les analyses médico-légales fausses ou trompeuses - y compris les croquis de police - auraient contribué à près de 25 % de toutes les condamnations injustifiées aux États-Unis. Sasha Luciano, chercheuse à la bibliothèque open source "Hugging Face" sur le traitement du langage naturel, a déclaré : « en général, le traitement des personnes de couleur sur Internet est très raciste et injuste, et ce préjugé se répercute sur les systèmes d'IA. Cela se reflète également dans les ensembles de données utilisés dans les projets d'IA. Ce sont les groupes marginalisés qui sont actuellement aliénés par la technologie ».

En outre, les développeurs de "Forensic Sketch AI-rtist" admettent également qu'il n'existe aucun indice permettant de mesurer la précision de l'image générée. DALL-E 2 contient de nombreux biais. Par exemple, le système serait connu pour afficher principalement des hommes blancs lorsqu'on lui demande de générer l'image d'un PDG. D'un autre côté, les développeurs de "Forensic Sketch AI-rtist" ont déclaré que leur programme fonctionne en partant du principe que les descriptions de la police sont dignes de confiance et que "les agents de police devraient être les responsables de l'assurance qu'un portrait-robot juste et honnête est partagé".

Mais ce dernier argument n'a pas non plus été bien accueilli par la communauté. Les critiques soulignent en effet que l'hypothèse de neutralité de la police avancée par les deux développeurs ignore les preuves bien documentées selon lesquelles les policiers mentent régulièrement lorsqu'ils présentent des preuves et témoignent dans des affaires criminelles. L'année dernière, un rapport du Center on Privacy & Technology a révélé que les outils de reconnaissance faciale de l'IA entraînent souvent des biais et des erreurs dans les affaires médico-légales. Le rapport indique que la reconnaissance faciale est une source peu fiable de preuves d'identité.

Il souligne également que les étapes algorithmiques et humaines d'une recherche de reconnaissance faciale peuvent aggraver les erreurs des autres. OpenAI a refusé de commenter l'utilisation de sa technologie dans le projet de Fortunato et Reynaud.

Source : Forensic Sketch AI-rtist

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous du système d'IA présenté ci-dessous ?

Selon vous, quelle est l'utilité de ce système d'IA ? Répond-il à un besoin réel ?

À votre avis, peut-on arriver à supprimer complètement les biais de ces systèmes d'IA ? Si oui, comment ?

Voir aussi

L'utilisation de la technologie de reconnaissance faciale ne répond pas aux normes éthiques et légales, trois cas d'utilisation ont montré une violation flagrante des droits de l'homme

UK : la technologie de reconnaissance faciale de la police aurait permis d'arrêter un suspect, grâce à l'amélioration du logiciel et de son algorithme

L'UE se prépare à construire un énorme système international de reconnaissance faciale, des propositions de loi permettent aux forces de police de l'UE de relier leurs bases de données photos

Les autorités iraniennes prévoient d'utiliser la reconnaissance faciale pour faire appliquer la loi sur le hijab, alors que des critiques craignent son utilisation à des fins d'espionnage

Répondre avec citation

Répondre avec citation

Partager