L'IA serait sur le point de créer des « nantis » et des « démunis » parmi les travailleurs du savoir,

selon une nouvelle étude

Les capacités de l'intelligence artificielle à produire un travail semblable à celui des humains se sont rapidement améliorées, en particulier depuis la publication de l’outil d’IA ChatGPT d'OpenAI, l'un des nombreux grands modèles de langage (LLM) qui sont largement disponibles pour un usage public. Les capacités de l'IA se confondant de plus en plus avec celles de l'homme, l'intégration du travail humain avec l'IA pose de nouveaux défis fondamentaux et offre de nouvelles possibilités, en particulier dans les domaines des travailleurs du savoir.

Le travailleur du savoir appartient à la catégorie des travailleurs intellectuels ou, en termes de gestion, à la catégorie des travailleurs du secteur quaternaire. Il possède le savoir-faire propre à l'entreprise et, par là, la capacité d'innover.

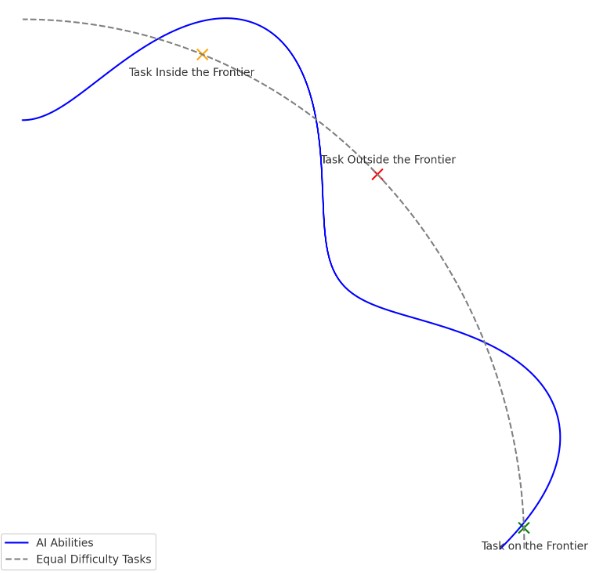

L’IA se rapprocherait des capacités humaines plus rapidement que prévu. Les développements rapides de l’IA dans des domaines tels que le traitement du langage naturel (NLP) ont relancé le débat sur ce concept qui serait pour certains observateurs largement spéculatif. Les chercheurs de la Harvard Business School et de Boston Consulting Group démontrent que les capacités de l'IA couvrent un domaine qu’ils ont appelé « frontière technologique en dents de scie ». À l'intérieur de cette frontière croissante, l'IA peut compléter ou même remplacer le travail humain. En dehors de cette frontière, les résultats de l'IA sont imprécis, moins utiles et dégradent les performances humaines.

Une IA de niveau humain serait une machine, ou un réseau de machines, capable d'effectuer la même gamme de tâches que celles dont nous sommes capables. Il s'agirait d'une machine « capable d'apprendre à faire tout ce qu'un humain peut faire », comme le disent Norvig et Russell dans leur manuel sur l'IA. Elle serait capable de choisir les actions qui lui permettent d'atteindre ses objectifs et de les exécuter. Elle serait capable de faire le travail d'un traducteur, d'un médecin, d'un illustrateur, d'un enseignant, d'un thérapeute, d'un chauffeur, ou le travail d'un investisseur.

Toutefois, comme les capacités de l'IA évoluent rapidement et seraient mal comprises, il peut être difficile pour les professionnels de saisir exactement les limites ce que les chercheurs de la Boston Consulting Group ont appélé « capable d'apprendre à faire tout ce qu'un humain peut faire ». Selon ces chercheurs, les professionnels qui naviguent habilement dans cette frontière obtiennent d'importants avantages en termes de productivité lorsqu'ils travaillent avec l'IA, tandis que l'IA peut en fait diminuer les performances lorsqu'elle est utilisée pour des travaux en dehors de cette frontière.

Voici ce que montre ChatGPT avec Code Interpreter :Envoyé par Harvard Business School

Pour tester l'impact réel de l'IA sur le travail du savoir, les chercheurs ont pris des centaines de consultants et déterminé au hasard s'ils étaient autorisés à utiliser l'IA. Ils ont donné à ceux qui étaient autorisés à utiliser l'IA l'accès à GPT-4, le même modèle auquel tout le monde dans 169 pays peut accéder gratuitement avec Bing, ou en payant 20 dollars par mois à OpenAI. Il n'y a pas eu d'ajustement spécial ou d'incitation, juste le GPT-4 par l'intermédiaire de l'API.

Ils ont ensuite effectué un grand nombre de pré-tests et d'enquêtes pour établir des bases de référence, et ont demandé à des consultants d'effectuer une grande variété de tâches pour une entreprise de chaussures fictive, tâches que l'équipe du Boston Consulting Group avait sélectionnées pour représenter fidèlement ce que font les consultants.

Il y avait des tâches créatives (« Proposer au moins 10 idées pour une nouvelle chaussure ciblant un marché ou un sport mal desservi »), des tâches analytiques (« Segmenter le marché de l'industrie de la chaussure en fonction des utilisateurs »), des tâches de rédaction et de marketing (« Rédiger un communiqué de presse pour le marketing de votre produit ») et des tâches de persuasion (« Rédiger un mémo d'inspiration pour les employés en détaillant pourquoi votre produit surpasserait les concurrents »). Les chercheurs ont vérifié auprès d'un dirigeant d'une entreprise de chaussures que ces tâches étaient réalistes – « elles l'étaient. Et, connaissant l'IA, il s'agit de tâches dont on peut s'attendre à ce qu'elles se situent à l'intérieur de la frontière. »

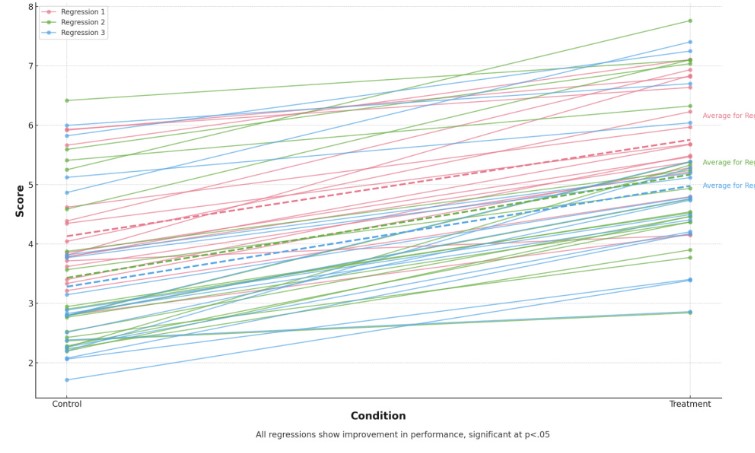

Les chercheurs ont constaté que les consultants ayant accès à l’IA ont obtenu de bien meilleurs résultats, qu’ils aient été brièvement initiés à l’IA (le groupe « aperçu » dans le diagramme) ou non. Cette constatation vaut pour toutes les mesures, qu'il s'agisse du temps nécessaire à l'accomplissement des tâches, du nombre total de tâches accomplies (nous leur avons donné une limite de temps globale) ou de la qualité des résultats.

La figure présente une série de lignes horizontales, chacune représentant l'estimation de l'effet du traitement pour une question spécifique telle qu'évaluée par les correcteurs humains et les modèles de régression linéaire pour chaque question. Il s'agit des trois modèles de régression présentés dans les colonnes 1 à 3 du tableau. Au total, il y a 54 lignes. 18 questions et 3 modèles de régression pour chaque question

En dehors de la frontière déchiquetée

Les chercheurs du Boston Consulting Group ont conçu une tâche supplémentaire, soigneusement sélectionnée pour s'assurer que l'IA ne puisse pas donner une réponse correcte. Cela n'a pas été facile. « Puisque l'IA s'est révélée étonnamment capable, il était difficile de concevoir une tâche dans cette expérience en dehors de la frontière de l'IA où les humains avec un capital humain élevé faisant leur travail seraient systématiquement plus performants que l'IA ».

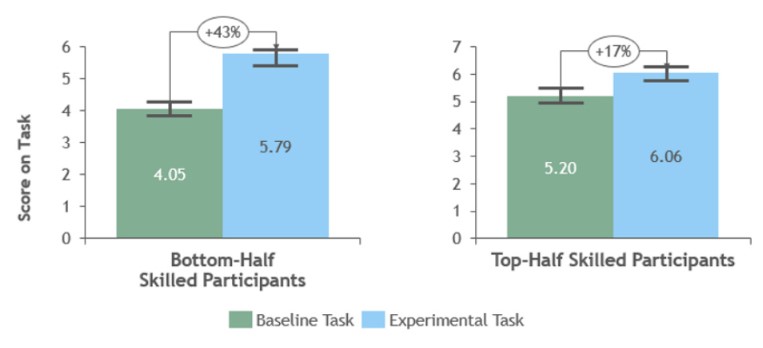

Mais ils ont identifié une tâche qui utilisait les points faibles de l'IA pour s'assurer qu'elle donnerait une réponse erronée, mais convaincante, à un problème que les humains seraient capables de résoudre. En effet, les consultants humains ont trouvé la bonne réponse dans 84 % des cas sans l'aide de l'IA, mais lorsque les consultants ont utilisé l'IA, ils ont fait pire : ils n'ont trouvé la bonne réponse que dans 60 à 70 % des cas. Que s'est-il passé ?

Compétences de la moitié inférieure et compétences de la moitié supérieure - Intérieur des frontières

Fabrizio Dell'Acqua de la Harvard Business School montre pourquoi le fait de trop compter sur l'IA peut se retourner contre soi. Lors d'une expérience, il a constaté que les recruteurs qui utilisaient une IA de haute qualité devenaient paresseux, négligents et moins compétents dans leur propre jugement. Ils ont manqué des candidats brillants et pris de moins bonnes décisions que les recruteurs qui utilisaient une IA de faible qualité ou pas d'IA du tout.

Lorsque l'IA est très bonne, les humains n'ont aucune raison de travailler dur et d'être attentifs. Ils laissent l'IA prendre le dessus, au lieu de l'utiliser comme un outil. C'est ce qu'il appelle « s'endormir au volant », et cela peut nuire à l'apprentissage, au développement des compétences et à la productivité des humains.

Il a également constaté que les consultants « s'endormaient au volant » - ceux qui utilisaient l'IA avaient en fait des réponses moins précises que ceux qui n'étaient pas autorisés à utiliser l'IA (mais ils ont tout de même fait un meilleur travail de rédaction des résultats que les consultants qui n'utilisaient pas l'IA). L'autorité de l'IA peut être trompeuse si l'on ne sait pas où se situe la frontière.

Source : Boston Consulting Group

Et vous ?

Les conclusions du rapport d'étude des chercheurs de la Boston Consulting Group sont-elles pertinentes ?

Partagez-vous l'idée selon laquelle, l'IA pourrait créer des « nantis » et des « démunis » ?

Voir aussi :

Quels sont les pays gagnants dans la course à la domination pour l'IA ? Les États-Unis sont premiers, la Chine, seconde et la France, sixième

L'atteinte d'une forme d'IA de niveau humain est-elle plus rapide que prévu ? Il y aurait une chance sur deux pour qu'une « AGI » soit conçue, testée et annoncée publiquement d'ici 2040

217 emplois supprimés et remplacés par l'IA en france, l'entreprise de veille médiatique Onclusive va supprimer ces emplois au profit de l'intelligence artificielle

Répondre avec citation

Répondre avec citation

Partager