Qui a utilisé ChatGPT, Claude, ou encore Bard pour ses créations ? Quelle est l’efficacité réelle des détecteurs de contenu IA ? Les réponses dans un sujet de recherche universitaire.

Un sujet de recherche universitaire étudie l'efficacité des outils de détection des contenus générés par l'IA. Dans un article, il présente l'idée de la détection directe de l'origine et évalue si les systèmes d'IA générative peuvent reconnaître leur production et la distinguer des textes écrits par des humains.

Depuis que ChatGPT a rendu la création de contenu écrit beaucoup plus facile qu'elle ne l'aurait été autrement, une multitude de détecteurs de contenu d'IA ont vu le jour. Nombreux sont ceux qui ont commencé à utiliser ces détecteurs parce que c'est le genre de chose qui pourrait leur permettre de repérer le contenu généré par l'IA. Mais quelle est l'efficacité de ces détecteurs de contenu ? Une étude menée par le département d'informatique de la Southern Methodist University a tenté d'apporter des réponses à cette question.

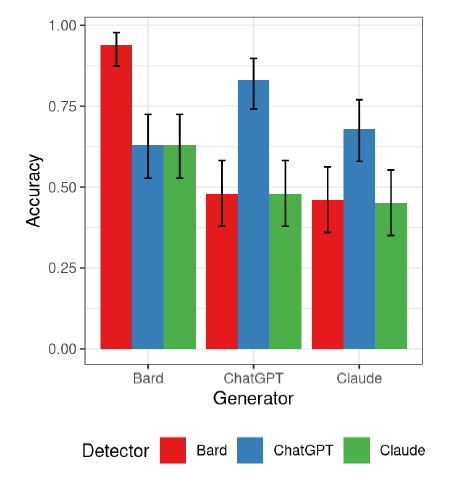

Les chercheurs ont analysé Claude, Bard et ChatGPT afin de déterminer lesquels étaient les plus faciles à détecter. Ceci étant dit, il est important de noter que Claude fournit un contenu qui échappe en grande partie à la détection. Quant à ChatGPT et Bard, ils ont mieux détecté leur propre contenu, mais ils n'ont pas été aussi bons que Claude lorsqu'il s'est agi d'éviter la détection par des outils tiers.

Les détecteurs de contenu d'IA recherchent des artefacts ou, en d'autres termes, des signes indiquant qu'un élément de contenu a été créé à l'aide de grands modèles de langage. Chaque LLM s'accompagne d'un ensemble unique d'artefacts, qui peuvent tous contribuer à les rendre plus ou moins difficiles à repérer une fois que tous les éléments ont été pris en compte.

Cette étude a consisté à générer un contenu de 250 mots pour une cinquantaine de sujets. Les trois modèles d'IA analysés ont ensuite été invités à paraphraser ce contenu, et cinquante essais générés par des humains ont également été pris en compte dans l'équation. Les modèles d'IA ont ensuite été soumis à un processus d'auto-détection à l'aide d'un système d'incitation de type "Zero Shot".

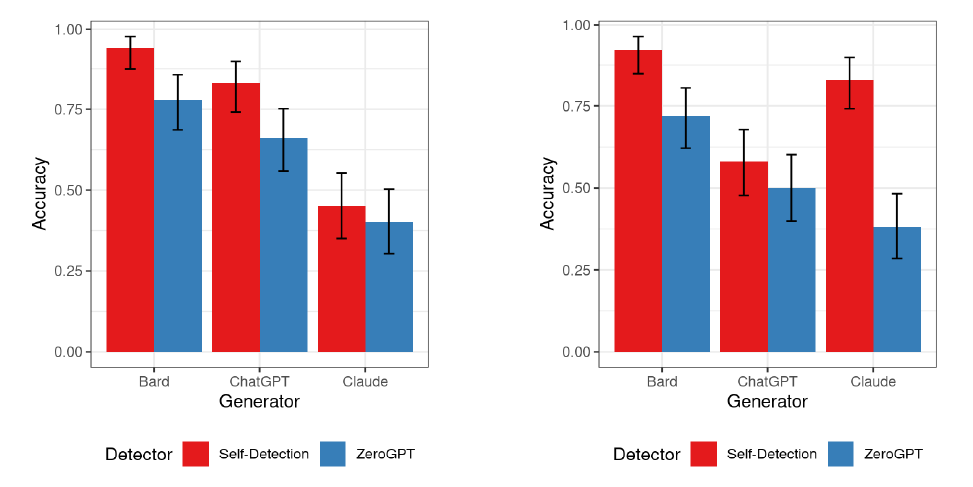

Bard a obtenu le plus haut niveau de précision lors de la détection de son propre contenu, suivi de ChatGPT et de Claude en dernière position. Quant à ZeroGPT, un détecteur de contenu proposé par Open AI, il a détecté le contenu de Bard dans environ 75 % des cas. Il a été légèrement moins efficace pour détecter le contenu généré par GPT, et Claude a réussi à lui faire croire que le contenu n'était pas généré par l'IA le plus souvent parmi tous les modèles.

Une chose qu'il faut mentionner ici est que l'autodétection de ChatGPT a oscillé autour de 50 %. Cela semble indiquer qu'elle a le même taux de précision que la devinette, qui a été considérée comme un échec dans le contexte de cette étude. L'autodétection du contenu paraphrasé a donné des résultats encore plus intéressants. Claude a enregistré un score d'autodétection beaucoup plus élevé, et il a également obtenu le score de précision le plus bas lorsqu'il a été détecté par ZeroGPT.

Au final, les chercheurs ont conclu que ChatGPT est capable de détecter le contenu qu'il a contribué à générer, mais qu'il semble moins efficace pour enregistrer le contenu paraphrasé. Bard a obtenu des résultats raisonnables dans les deux cas, mais chacun de ces modèles a été largement dépassé par Claude.

Claude a été capable de surpasser non seulement les autres modèles d'IA, mais aussi sa propre détection. Cela semble indiquer qu'il avait le moins d'artefacts pouvant être utilisés pour déterminer l'origine de son contenu. D'autres études seront nécessaires pour obtenir des preuves supplémentaires, mais tout porte à croire que Claude est le générateur de texte le plus fiable de tous.

Autodétection du contenu d'IA pour les grands modèles de langage basés sur les transformateurs

Résumé

L'utilisation d'outils d'intelligence artificielle générative (IA) basés sur de grands modèles de langage, tels que ChatGPT, Bard et Claude, pour la génération de textes a de nombreuses applications passionnantes avec un potentiel de gains de productivité phénoménaux. L'une des questions qui se posent est celle de l'attribution de la paternité du texte lors de l'utilisation d'outils d'intelligence artificielle. Cette question est particulièrement importante dans un cadre universitaire, où l'utilisation inappropriée d'outils d'IA générative peut entraver l'apprentissage des étudiants ou étouffer la recherche en créant une grande quantité de travaux dérivés générés automatiquement.

Les systèmes existants de détection du plagiat peuvent retracer la source du texte soumis, mais ne sont pas encore équipés de méthodes permettant de détecter avec précision les textes générés par l'IA. Cet article présente l'idée de la détection directe de l'origine et évalue si les systèmes d'IA générative peuvent reconnaître leur production et la distinguer des textes écrits par des humains. Nous expliquons pourquoi les modèles actuels basés sur les transformateurs peuvent être capables d'autodétecter leur propre texte généré et nous réalisons une petite étude empirique utilisant l'apprentissage à partir de zéro pour vérifier si c'est le cas. Les résultats révèlent des capacités variables des systèmes d'IA à identifier leur texte généré. Le modèle Bard de Google présente la plus grande capacité d'autodétection avec une précision de 94 %, suivi par ChatGPT d'OpenAI avec 83 %. En revanche, le modèle Claude d'Anthropic semble incapable de s'autodétecter.

Conclusion

La détection des contenus générés par l'IA, qui comprend l'attribution correcte de la paternité et la résolution des questions de rémunération du créateur du contenu utilisé pour former ces modèles, devient de plus en plus importante pour de nombreuses applications. Dans le monde universitaire en particulier, l'IA générative a de nombreuses utilisations qui peuvent améliorer l'apprentissage en générant des explications pour les étudiants, mais elle peut aussi nuire à l'apprentissage en permettant aux étudiants de laisser l'IA résoudre leurs exercices.

La contribution unique de cette étude réside dans l'introduction de l'autodétection, un pas en avant pour relever les défis posés par les systèmes d'IA. Nous décrivons pourquoi les systèmes à base de transformateurs devraient avoir la capacité de s'autodétecter et nous démontrons cette capacité dans une première petite étude. Nous identifions la principale limitation de l'autodétection comme étant l'indisponibilité de l'invite d'origine.

La première étude présentée est très limitée. Voici quelques sujets à explorer dans de futures études.

- Utiliser un ensemble de données plus important avec des textes générés plus diversifiés.

- Explorer davantage de modèles d'IA génératifs différents.

- Comparer les performances de l'autodétection avec les meilleurs détecteurs actuels.

- Étudier l'influence de l'ingénierie de l'invite sur l'autodétection. Par exemple, utiliser des messages courts pour l'autodétection.

Source : "AI Content Self-Detection for Transformer-based Large Language Models", Southern Methodist University

Et vous ?

Pensez-vous que cette étude est crédible ou pertinente ?

Quel est votre avis sur le sujet ?

Voir aussi :

Lutte pour une science authentique : Un système de détection de texte généré par l'IA place la barre plus haut, d'après une recherche de l'Université du Kansas

Une étude affirme que les internautes ne parviennent à détecter avec précision les textes générés par l'IA que dans 50 % des cas, et une autre estime que les outils de détection ne sont pas fiables

Les détecteurs de contenu GPTZero et Turnitin rivalisent pour la suprématie de l'IA dans le milieu académique, afin de répondre à l'essor des générateurs de texte d'IA générative, selon Similarweb

Répondre avec citation

Répondre avec citation

Partager